Testa AI på DIN webbplats på 60 sekunder

Se hur vår AI omedelbart analyserar din webbplats och skapar en personlig chatbot - utan registrering. Ange bara din URL och se hur det fungerar!

Introduktion till AI och datasekretess

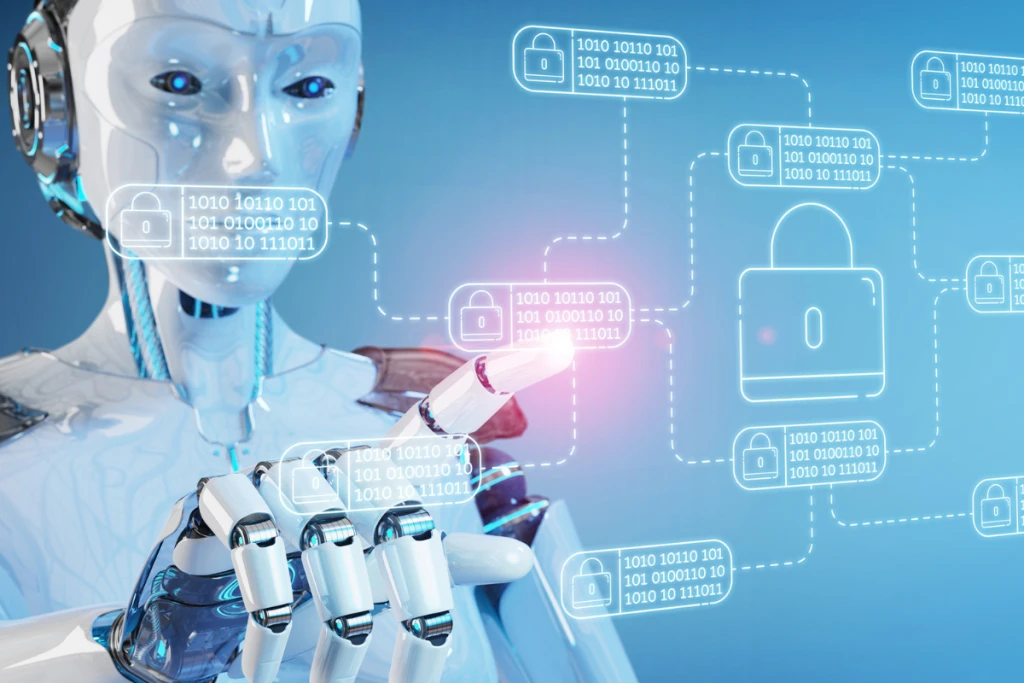

Datasekretess avser skydd av personlig information från obehörig åtkomst, missbruk eller exponering. AI-system kräver ofta omfattande datauppsättningar för att fungera effektivt, vilket leder till potentiella risker som dataintrång, identitetsstöld och algoritmiska fördomar. När AI fortsätter att utvecklas är det viktigt att balansera innovation med etiska och juridiska överväganden för att säkerställa att användardata förblir säker.

Sekretessutmaningar i AI-tiden

Massiv datainsamling

Många AI-applikationer, som rekommendationssystem, ansiktsigenkänningsteknik och röstassistenter, kräver stora mängder data för att förbättra deras noggrannhet och prestanda. Detta leder till kontinuerlig datainsamling från användare, ofta utan deras uttryckliga vetskap eller samtycke. Sociala medieplattformar spårar till exempel användarinteraktioner för att förfina sina algoritmer, men denna praxis kan sudda ut gränsen mellan personliga upplevelser och invasiv övervakning.

Brist på transparens

En av de största problemen med AI är dess "black box"-natur. Många AI-drivna beslut är inte lätta att förklara, vilket gör det svårt för användare att förstå hur deras data används. Om en AI-modell nekar en person ett lån eller en jobbmöjlighet baserat på dess analys, kanske den drabbade individen inte har något sätt att förstå eller utmana beslutet. Denna brist på transparens kan undergräva förtroendet för AI-system och väcka etiska problem.

Partiskhet och diskriminering

AI-system tränas med hjälp av historiska data, som kan innehålla inneboende fördomar. Om de inte hanteras noggrant kan AI-modeller vidmakthålla eller till och med förstärka diskriminering. Till exempel har partiska system för ansiktsigenkänning visat sig felidentifiera individer från vissa demografiska grupper i högre takt. Detta väcker inte bara etiska problem utan också juridiska risker för företag som förlitar sig på AI-baserat beslutsfattande.

Förbättrad övervakning

AI-drivna övervakningsverktyg, som ansiktsigenkänning och beteendespårning, blir allt vanligare. Även om dessa tekniker kan förbättra säkerheten, utgör de också allvarliga hot mot integriteten. Regeringar och företag kan använda AI för att övervaka individer utan deras samtycke, vilket ger upphov till oro för massövervakning och potentiellt missbruk av personuppgifter.

Bästa metoder för att skydda personuppgifter i AI-applikationer

Dataminimering

Organisationer bör endast samla in den data som behövs för deras AI-applikationer. Att minska mängden lagrad personlig information minimerar risken för dataexponering i händelse av intrång.

Datamaskering och pseudonymisering

Tekniker som datamaskering (ersätter känsliga data med fiktiva värden) och pseudonymisering (ta bort direkta identifierare från datauppsättningar) kan förbättra integriteten samtidigt som AI-modeller kan fungera effektivt.

Informerat samtycke och användarmedvetenhet

Användare bör ha tydlig och tillgänglig information om hur deras data samlas in, används och lagras. Implementering av opt-in-policyer snarare än automatisk datainsamling säkerställer större transparens och användarkontroll.

Regelbundna säkerhetsrevisioner

AI-system bör genomgå täta säkerhetsrevisioner för att identifiera sårbarheter och potentiella integritetsrisker. Detta inkluderar testning av dataläckor, obehörig åtkomst och fördomsdetektering.

Robusta krypteringsprotokoll

Kryptering av lagrad och överförd data lägger till ett extra lager av säkerhet, vilket gör det svårare för obehöriga parter att komma åt känslig information.

Regelverk och efterlevnad

General Data Protection Regulation (GDPR)

GDPR, som upprätthålls av EU, sätter strikta riktlinjer för datainsamling, lagring och användarsamtycke. Företag måste tillhandahålla öppenhet angående dataanvändning och tillåta individer att begära radering av uppgifter.

California Consumer Privacy Act (CCPA)

Denna amerikanska förordning ger invånare i Kalifornien större kontroll över sina personuppgifter, vilket kräver att företag avslöjar metoder för datainsamling och erbjuder alternativ för att välja bort.

AI-specifika etiska riktlinjer

Flera organisationer, inklusive OECD och UNESCO, har infört etiska AI-riktlinjer som betonar transparens, rättvisa och ansvarsskyldighet i AI-utveckling och implementering.

Organisationers roll för att säkerställa datasekretess

Utveckla etiska ramverk för AI: Fastställande av interna riktlinjer för AI-utveckling som prioriterar användarnas integritet och etiska överväganden.

Utbilda anställda om dataskydd: Utbilda personal om bästa praxis för datasäkerhet och efterlevnad av integritetsbestämmelser.

Implementera Privacy by Design: Integrering av dataskyddsåtgärder i utvecklingsstadiet av AI-projekt snarare än som en eftertanke.

Engagera sig i transparent kommunikation: Ger tydliga förklaringar till användarna om hur deras data används och säkerställer att de har kontroll över sin information.

Framtidsutsikter: Balansera innovation och integritet

Federated Learning: Ett decentraliserat tillvägagångssätt för AI-träning som gör att modeller kan lära sig av data utan att överföra dem till en central server, vilket förbättrar integriteten.

AI-förordning och etisk AI-utveckling: Regeringar över hela världen förväntas införa strängare AI-regler för att förhindra missbruk och säkerställa dataskydd.

Större användarkontroll över data: Framväxande teknologier kan erbjuda individer mer kontroll över sina personuppgifter, till exempel självsuveräna identitetssystem som använder blockchain.