Testa DITT Företag på Minuter

Skapa ditt konto och lansera din AI-chatbot på några minuter. Helt anpassningsbar, ingen kodning krävs - börja engagera dina kunder direkt!

Magin bakom chattfönstret

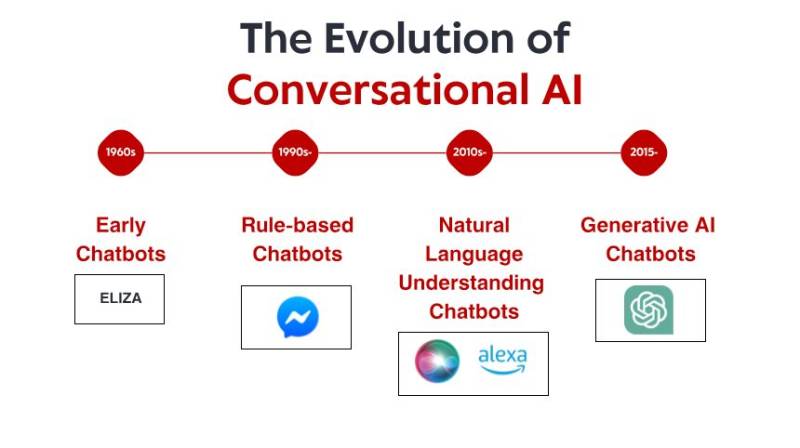

Den skenbara enkelheten hos moderna chattrobotar maskerar en otroligt sofistikerad teknologisk orkester som spelar bakom kulisserna. Det som ser ut som ett enkelt textutbyte involverar flera specialiserade AI-system som arbetar tillsammans: bearbetar ditt språk, hämtar relevant information, genererar lämpliga svar och lär sig ständigt av interaktioner.

Som någon som har tillbringat år med att utveckla och implementera chattrobotsystem för olika branscher har jag haft en plats på första parkett i deras anmärkningsvärda utveckling. Många användare är förvånade över att få veta att moderna chattrobotar inte är enskilda AI-program utan snarare komplexa ekosystem av specialiserade komponenter som arbetar tillsammans. Att förstå dessa komponenter avmystifierar inte bara vad som ibland kan kännas som teknologisk magi, utan hjälper oss också att bättre uppskatta både deras möjligheter och begränsningar.

I den här utforskningen ska vi dra åt sidan för moderna chattrobotar för att förstå de viktigaste teknologierna bakom dem, hur dessa system tränas och hur de övervinner de grundläggande utmaningarna med mänskligt språk. Oavsett om du funderar på att implementera en chattrobot för ditt företag eller helt enkelt är nyfiken på den teknik du interagerar med dagligen, kommer den här rundturen bakom kulisserna att ge värdefulla insikter i en av AI:s mest synliga tillämpningar.

Grunden: Stora språkmodeller

Skalan på dessa modeller är svår att förstå. De största LLM:erna har hundratals miljarder parametrar – de justerbara värden som modellen använder för att göra förutsägelser. Under träningen förfinas dessa parametrar gradvis allt eftersom modellen bearbetar massiva datamängder bestående av böcker, artiklar, webbplatser, kodförråd och annan text – ofta uppgående till biljoner ord.

Genom denna träningsprocess utvecklar språkmodeller en statistisk förståelse för hur språk fungerar. De lär sig ordförråd, grammatik, fakta om världen, resonemangsmönster och till och med en viss grad av sunt förnuft. Viktigt är att de inte bara memorerar sina träningsdata – de lär sig generaliserbara mönster som gör att de kan hantera nya indata som de aldrig sett förut.

När du skickar ett meddelande till en chatbot som drivs av en LLM, konverteras din text först till numeriska representationer som kallas tokens. Modellen bearbetar dessa tokens genom sina många lager av neurala kopplingar, vilket slutligen producerar sannolikhetsfördelningar för vilka tokens som ska komma härnäst i ett svar. Systemet konverterar sedan tillbaka dessa tokens till mänskligt läsbar text.

De mest avancerade språkmodellerna idag inkluderar:

GPT-4: OpenAI:s modell driver ChatGPT och många andra kommersiella applikationer, känd för sina starka resonemangsförmågor och breda kunskaper.

Claude: Anthropics modellfamilj, utformad med betoning på hjälpsamhet, ofarlighet och ärlighet.

Llama 3: Metas öppna viktmodeller, som har demokratiserat tillgången till kraftfull LLM-teknik.

Gemini: Googles multimodala modeller som kan bearbeta både text och bilder.

Mistral: En familj av effektiva modeller som levererar imponerande prestanda trots mindre parameterantal.

Trots sina anmärkningsvärda funktioner har basspråksmodeller ensamma betydande begränsningar som konversationsagenter. De har ingen tillgång till information i realtid, kan inte söka på webben eller i databaser för att verifiera fakta och "hallucinerar" ofta – de genererar trovärdig men felaktig information. Dessutom saknar de kunskap om specifika företag, produkter eller användarkontexter utan ytterligare anpassning.

Det är därför moderna chatbotarkitekturer integrerar LLM:er med flera andra viktiga komponenter för att skapa verkligt användbara konversationssystem.

Retrieval-Augmented Generation: Att förankra chatbotar i fakta

RAG-system fungerar genom att kombinera språkmodellernas generativa kapacitet med precisionen hos informationshämtningssystem. Så här flyter en typisk RAG-process i en modern chatbot:

Frågebehandling: När en användare ställer en fråga analyserar systemet den för att identifiera viktiga informationsbehov.

Informationshämtning: Istället för att enbart förlita sig på LLM:ens träningsdata söker systemet igenom relevanta kunskapsbaser – vilket kan inkludera företagsdokumentation, produktkataloger, vanliga frågor eller till och med liveinnehållet på en webbplats.

Relevant dokumentval: Hämtningssystemet identifierar de mest relevanta dokumenten eller avsnitten baserat på semantisk likhet med frågan.

Kontextförstärkning: Dessa hämtade dokument tillhandahålls språkmodellen som ytterligare kontext när den genererar dess svar.

Svarsgenerering: LLM:n producerar ett svar som innehåller både dess allmänna språkliga kapacitet och den specifika hämtade informationen.

Källattribution: Många RAG-system spårar också vilka källor som bidrog till svaret, vilket möjliggör citering eller verifiering.

Denna metod kombinerar det bästa av två världar: LLM:ns förmåga att förstå frågor och generera naturligt språk, med noggrannheten och den aktuella informationen från hämtningssystem. Resultatet är en chatbot som kan ge specifik, faktabaserad information om produkter, policyer eller tjänster utan att tillgripa hallucinationer.

Tänk dig en chatbot för e-handelskundtjänst. När en ren LLM tillfrågas om returpolicyer för en specifik produkt kan den generera ett rimligt men potentiellt felaktigt svar baserat på allmänna mönster som observerats under utbildningen. En RAG-förstärkt chatbot skulle istället hämta företagets faktiska returpolicydokument, hitta det relevanta avsnittet om den produktkategorin och generera ett svar som korrekt återspeglar den nuvarande policyn.

Sofistikeringen av RAG-system fortsätter att utvecklas. Moderna implementeringar använder täta vektorinbäddningar för att representera både frågor och dokument i ett högdimensionellt semantiskt utrymme, vilket möjliggör hämtning baserat på betydelse snarare än bara nyckelordsmatchning. Vissa system använder hämtningspipelines i flera steg, där man först kastar ett brett nät och sedan förfinar resultaten genom omrankning. Andra avgör dynamiskt när hämtning är nödvändig kontra när den juridiska ledaren säkert kan svara från sin parametriska kunskap.

För företag som implementerar chattrobotar kräver effektiv RAG-implementering genomtänkt förberedelse av kunskapsbasen – att organisera information i hämtbara bitar, regelbundet uppdatera innehåll och strukturera data på sätt som underlättar korrekt hämtning. När RAG implementeras korrekt förbättrar det dramatiskt chattrobotarnas noggrannhet, särskilt för domänspecifika applikationer där precision är avgörande.

Hantering av konversationstillstånd: Bibehålla kontext

Moderna chattrobotar använder sofistikerade system för hantering av konversationsstatus för att upprätthålla sammanhängande, kontextuella utbyten. Dessa system spårar inte bara det explicita innehållet i meddelanden utan också det implicita sammanhang som människor naturligt upprätthåller under samtal.

Den mest grundläggande formen av tillståndshantering är spårning av konversationshistorik. Systemet upprätthåller en buffert av senaste utbyten (både användarinmatningar och egna svar) som tillhandahålls språkmodellen med varje ny fråga. Men när konversationerna blir längre blir det opraktiskt att inkludera hela historiken på grund av kontextlängdsbegränsningarna hos även de mest avancerade LLM:erna.

För att hantera denna begränsning använder sofistikerade chattrobotar flera tekniker:

Sammanfattning: Regelbundet kondensera tidigare delar av konversationen till koncisa sammanfattningar som fångar viktig information samtidigt som de minskar tokenanvändningen.

Entitetsspårning: Explicit övervakning av viktiga enheter (personer, produkter, problem) som nämns under hela konversationen och upprätthållande av dem i ett strukturerat tillstånd. Medvetenhet om konversationsstadier: Spårning av var i ett processflöde konversationen befinner sig för närvarande – oavsett om det gäller att samla in information, föreslå lösningar eller bekräfta åtgärder. Användarkontextbeständighet: Upprätthållande av relevant användarinformation över sessioner, såsom preferenser, köphistorik eller kontouppgifter (med lämpliga integritetskontroller). Intentminne: Minnes användarens ursprungliga mål även genom omvägar och förtydliganden i konversationen. Tänk dig ett kundtjänstscenario: En användare börjar fråga om att uppgradera sin prenumerationsplan och ställer sedan flera detaljerade frågor om funktioner, prisjämförelser och faktureringscykler innan hen slutligen bestämmer sig för att fortsätta med uppgraderingen. Ett effektivt system för hantering av konversationsstatus säkerställer att när användaren säger "Ja, vi gör det", förstår chatboten exakt vad "den" syftar på (uppgraderingen) och har behållit alla relevanta detaljer från den slingrande konversationen. Den tekniska implementeringen av tillståndshantering varierar mellan plattformar. Vissa system använder en hybridmetod som kombinerar spårning av symboliskt tillstånd (explicit modellering av entiteter och avsikter) med de implicita funktionerna hos stora kontextfönster i moderna LLM:er. Andra använder specialiserade minnesmoduler som selektivt hämtar relevanta delar av konversationshistoriken baserat på den aktuella frågan.

För komplexa applikationer som kundtjänst eller försäljning integreras tillståndshantering ofta med affärsprocessmodellering, vilket gör det möjligt för chattrobotar att vägleda konversationer genom definierade arbetsflöden samtidigt som de bibehåller flexibilitet för naturlig interaktion. De mest avancerade implementeringarna kan till och med spåra känslomässigt tillstånd tillsammans med faktisk kontext och justera kommunikationsstilen baserat på upptäckt användarsentiment.

Effektiv kontexthantering omvandlar chattrobotinteraktioner från osammanhängande fråge- och svarsutbyten till genuina konversationer som bygger på gemensam förståelse – en avgörande faktor för användarnöjdhet och slutförandegrad.

Förståelse av naturligt språk: Tolkning av användaravsikt

Moderna NLU-system i chatbotar utför vanligtvis flera viktiga funktioner:

Intentionsigenkänning: Identifiera användarens underliggande mål eller syfte. Försöker användaren göra ett köp, rapportera ett problem, begära information eller något annat? Avancerade system kan känna igen flera eller kapslade avsikter i ett enda meddelande.

Entitetsutvinning: Identifiera och kategorisera specifika informationsbitar i användarens meddelande. Till exempel, i "Jag behöver ändra mitt flyg från Chicago till Boston på torsdag" inkluderar entiteterna platser (Chicago, Boston) och tid (torsdag).

Sentimentanalys: Upptäcka känslomässig ton och attityd, vilket hjälper chatboten att justera sin svarsstil på lämpligt sätt. Är användaren frustrerad, upphetsad, förvirrad eller neutral?

Språkidentifiering: Att avgöra vilket språk användaren talar för att ge lämpliga svar i flerspråkiga miljöer. Medan tidigare chatbotplattformar krävde explicit programmering av avsikter och entiteter, utnyttjar moderna system de inneboende språkförståelsefunktionerna hos LLM:er. Detta gör det möjligt för dem att hantera ett mycket bredare spektrum av uttryck utan att kräva en uttömmande uppräkning av möjliga fraser. När en användare skriver "Utcheckningsprocessen fryser på betalningssidan" skulle ett sofistikerat NLU-system identifiera detta som en teknisk supportavsikt, extrahera "utcheckningsprocess" och "betalningssida" som relevanta entiteter, upptäcka frustration i sentimentet och dirigera denna information till lämplig svarsgenereringsväg. Noggrannheten hos NLU påverkar användarnöjdheten avsevärt. När en chatbot konsekvent misstolkar förfrågningar förlorar användare snabbt förtroende och tålamod. För att förbättra noggrannheten använder många system förtroendepoängsättning – när förtroendet för förståelsen faller under vissa tröskelvärden kan chatboten ställa förtydligande frågor snarare än att fortsätta med potentiellt felaktiga antaganden. För domänspecifika applikationer innehåller NLU-system ofta specialiserad terminologi och jargongigenkänning. En chatbot för hälso- och sjukvården skulle till exempel tränas att känna igen medicinska termer och symtom, medan en bot för finansiella tjänster skulle förstå bankterminologi och transaktionstyper.

Integrationen av NLU med de andra komponenterna är avgörande. De extraherade intentionerna och entiteterna informerar hämtningsprocesser, hjälper till att upprätthålla konversationstillståndet och vägleder svarsgenerering – och fungerar som den kritiska länken mellan vad användarna säger och vad systemet gör.

Testa DITT Företag på Minuter

Skapa ditt konto och lansera din AI-chatbot på några minuter. Helt anpassningsbar, ingen kodning krävs - börja engagera dina kunder direkt!

Svarsgenerering och optimering

I moderna system involverar svarsgenerering vanligtvis flera steg:

Svarsplanering: Att bestämma vilken information som ska inkluderas, frågor som ska ställas eller åtgärder som ska föreslås baserat på det aktuella konversationsläget och tillgänglig kunskap.

Innehållsval: Att välja vilka specifika fakta, förklaringar eller alternativ som ska presenteras från potentiellt stora mängder relevant information.

Strukturering: Att organisera det valda innehållet i en logisk, lättförståelig sekvens som effektivt tillgodoser användarens behov.

Realisering: Att omvandla det planerade innehållet till naturligt, flytande språk som matchar chatbotens önskade ton och stil.

Även om LLM:er kan generera imponerande sammanhängande text, leder okontrollerad generering ofta till problem som överdriven ordgrannhet, inkludering av irrelevant information eller svar som inte överensstämmer med affärsmålen. För att hantera dessa problem implementerar sofistikerade chatbotsystem olika optimeringstekniker:

Svarsmallar: För vanliga scenarier med förutsägbara informationsbehov använder många system parametriserade mallar som säkerställer konsekventa och effektiva svar samtidigt som de möjliggör personalisering.

Längdkontroll: Mekanismer för att justera svarslängden baserat på frågans komplexitet, plattformen där interaktionen sker och användarpreferenser.

Ton- och stilvägledning: Instruktioner som justerar formaliteten, vänligheten eller den tekniska nivån på svar baserat på konversationens sammanhang och användaregenskaper.

Planering över flera vändningar: För komplexa ämnen kan system planera svar över flera vändningar och avsiktligt dela upp information i lättsmälta bitar snarare än att överbelasta användare med textväggar.

Integration av affärslogik: Regler som säkerställer att svaren överensstämmer med affärspolicyer, myndighetskrav och servicemöjligheter.

De mest effektiva chatbotarna använder också adaptiva svarsstrategier. De övervakar användarengagemang och nöjdhetssignaler för att förfina sin kommunikationsmetod över tid. Om användare ofta ber om förtydliganden efter en viss typ av svar kan systemet automatiskt justera för att ge mer detaljerade förklaringar i liknande framtida scenarier.

En avgörande aspekt av svarsgenerering är att hantera osäkerhet. När information är otillgänglig eller tvetydig erkänner väl utformade system begränsningar snarare än att generera självsäkra men potentiellt felaktiga svar. Denna transparens bygger förtroende och hanterar användarnas förväntningar effektivt.

För verksamhetskritiska applikationer som hälso- och sjukvård eller finansiella tjänster inkluderar många implementeringar mänskliga granskningsmekanismer för vissa typer av svar innan de når användarna. Dessa skyddsräcken ger ett extra lager av kvalitetskontroll för interaktioner med hög insats.

Specialiserade moduler för åtgärder och integration

Dessa handlingsmöjligheter implementeras genom specialiserade moduler som kopplar samman konversationsgränssnittet med externa system:

API-integrationsramverk: Ett mellanprogramlager som översätter konversationsförfrågningar till korrekt formaterade API-anrop till olika backend-tjänster – beställningssystem, CRM-plattformar, betalningsprocessorer, bokningssystem etc.

Autentisering och auktorisering: Säkerhetskomponenter som verifierar användaridentitet och behörighetsnivåer innan de utför känsliga åtgärder eller får åtkomst till skyddad information.

Hjälp med formulärfyllning: Moduler som hjälper användare att fylla i komplexa formulär genom konversationsinteraktion, samla in nödvändig information bit för bit snarare än att presentera överväldigande formulär.

Transaktionsbehandling: Komponenter som hanterar flerstegsprocesser som köp, bokningar eller kontoändringar, upprätthåller tillstånd genom hela processen och hanterar undantag smidigt.

Meddelandesystem: Möjlighet att skicka uppdateringar, bekräftelser eller aviseringar via olika kanaler (e-post, SMS, aviseringar i appen) allt eftersom åtgärder fortskrider eller slutförs.

Sofistikeringen av dessa integrationer varierar kraftigt mellan olika implementeringar. Enkla chattrobotar kan inkludera grundläggande "handoff"-funktionalitet som överför användare till mänskliga agenter eller specialiserade system när åtgärd krävs. Mer avancerade implementeringar erbjuder sömlösa helhetsupplevelser där chattroboten hanterar hela processen inom konversationen.

Tänk dig en flygbolagschattbot som hjälper en passagerare att ändra en flygning. Den behöver:

Autentisera användaren och hämta deras bokning

Söka efter tillgängliga alternativa flyg

Beräkna eventuella prisskillnader eller ändringsavgifter

Bearbeta betalning vid behov

Utfärda nya boardingkort

Uppdatera bokningen i flera system

Skicka bekräftelseinformation via föredragna kanaler

För att uppnå detta krävs integration med bokningssystem, betalningsprocessorer, autentiseringstjänster och aviseringsplattformar – allt orkestrerat av chattroboten samtidigt som ett naturligt konversationsflöde bibehålls.

För företag som bygger handlingsorienterade chattrobotar representerar detta integrationslager ofta den mest betydande utvecklingsinsatsen. Medan konversationskomponenterna drar nytta av framsteg inom generell AI, måste dessa integrationer anpassas för varje organisations specifika systemlandskap.

Säkerhetsaspekter är särskilt viktiga för handlingskraftiga chattrobotar. Bästa praxis inkluderar att implementera korrekt autentisering före känsliga operationer, upprätthålla detaljerade granskningsloggar över alla vidtagna åtgärder, tillhandahålla tydliga bekräftelsesteg för följdåtgärder och utforma smidig felhantering när integrationer stöter på problem.

I takt med att dessa integrationsfunktioner utvecklas fortsätter gränsen mellan konversationsgränssnitt och traditionella applikationer att suddas ut. De mest sofistikerade implementeringarna idag gör det möjligt för användare att utföra komplexa uppgifter helt genom naturlig konversation som tidigare skulle ha krävt navigering på flera skärmar i traditionella applikationer.

Utbildning och kontinuerlig förbättring

Flera metoder för utbildning och förbättring samverkar:

Finjustering av grundmodellen: De grundläggande språkmodellerna som driver chattrobotar kan specialiseras ytterligare genom ytterligare utbildning på domänspecifik data. Denna process, kallad finjustering, hjälper modellen att anta lämplig terminologi, resonemangsmönster och domänkunskap för specifika applikationer.

Förstärkningsinlärning från mänsklig feedback (RLHF): Denna teknik använder mänskliga utvärderare för att betygsätta modellsvar och skapa preferensdata som tränar belöningsmodeller. Dessa belöningsmodeller vägleder sedan systemet mot att generera mer användbara, exakta och säkra resultat. RLHF har varit avgörande för att flytta språkmodeller från imponerande men opålitliga generatorer till praktiska assistenter.

Konversationsutvinning: Analyssystem som bearbetar anonymiserade konversationsloggar för att identifiera mönster, vanliga frågor, frekventa felpunkter och framgångsrika lösningsvägar. Dessa insikter driver både automatiserade förbättringar och vägleder människoledda förbättringar.

Aktivt lärande: System som identifierar osäkerhetsområden och flaggar dessa fall för mänsklig granskning, med fokus på de mest värdefulla förbättringsmöjligheterna. A/B-testning: Experimentella ramverk som jämför olika svarsstrategier med verkliga användare för att avgöra vilka metoder som är mest effektiva för olika scenarier. För företagschattrobotar börjar utbildningsprocessen vanligtvis med historisk data – tidigare kundtjänstutskrifter, dokumentation och produktinformation. Denna inledande utbildning kompletteras sedan med noggrant utformade exempelkonversationer som visar idealisk hantering av vanliga scenarier. När de väl är driftsatta inkluderar effektiva system feedbackmekanismer som gör det möjligt för användare att ange om svaren var hjälpsamma. Denna feedback, i kombination med implicita signaler som att samtalet avbröts eller upprepade frågor, skapar en rik datauppsättning för kontinuerlig förbättring. Den mänskliga rollen i utbildningen av moderna chattrobotar är fortfarande avgörande. Konversationsdesigners skapar de centrala personlighets- och kommunikationsmönstren. Ämnesexperter granskar och korrigerar föreslagna svar för teknisk noggrannhet. Dataforskare analyserar prestandamått för att identifiera förbättringsmöjligheter. De mest framgångsrika implementeringarna behandlar chattrobotutveckling som ett samarbetspartnerskap mellan människa och AI snarare än en helt automatiserad process. För företag som implementerar chattrobotar är det avgörande att etablera ett tydligt förbättringsramverk. Detta inkluderar:

Regelbundna prestationsgranskningscykler

Dedikerad personal för övervakning och förfining

Tydliga framgångsmått

Processer för att införliva användarfeedback

Styrning för att hantera utbildningsdatakvalitet

Även om de specifika metoderna varierar mellan plattformar och applikationer, förblir den grundläggande principen konsekvent: moderna chattrobotar är dynamiska system som förbättras genom användning, feedback och avsiktlig förfining snarare än statiska program som är låsta i sina initiala funktioner.

Skyddsåtgärder och etiska överväganden

These safeguards typically include:

Content Filtering: Systems that detect and prevent harmful, offensive, or inappropriate content in both user inputs and model outputs. Modern implementations use specialized models specifically trained to identify problematic content across various categories.

Scope Enforcement: Mechanisms that keep conversations within appropriate domains, preventing chatbots from being manipulated into providing advice or information outside their intended purpose and expertise.

Data Privacy Controls: Protections for sensitive user information, including data minimization principles, anonymization techniques, and explicit consent mechanisms for data storage or usage.

Bias Mitigation: Processes that identify and reduce unfair biases in training data and model outputs, ensuring equitable treatment across different user groups.

External Reference Verification: For factual claims, particularly in sensitive domains, systems that verify information against trusted external sources before presenting it to users.

Human Oversight: For critical applications, review mechanisms that enable human monitoring and intervention when necessary, particularly for consequential decisions or sensitive topics.

The implementation of these safeguards involves both technical and policy components. At the technical level, various filtering models, detection algorithms, and monitoring systems work together to identify problematic interactions. At the policy level, clear guidelines define appropriate use cases, required disclaimers, and escalation paths.

Healthcare chatbots provide a clear example of these principles in action. Well-designed systems in this domain typically include explicit disclaimers about their limitations, avoid diagnostic language unless medically validated, maintain strict privacy controls for health information, and include clear escalation paths to human medical professionals for appropriate concerns.

For businesses implementing chatbots, several best practices have emerged:

Start with clear ethical guidelines and use case boundaries

Implement multiple layers of safety mechanisms rather than relying on a single approach

Test extensively with diverse user groups and scenarios

Establish monitoring and incident response protocols

Provide transparent information to users about the system's capabilities and limitations

As conversational AI becomes more powerful, the importance of these safeguards only increases. The most successful implementations balance innovation with responsibility, ensuring that chatbots remain helpful tools that enhance human capabilities rather than creating new risks or harms.

The Future of Chatbot Technology

While today's chatbots have come remarkably far from their primitive ancestors, the technology continues to evolve rapidly. Several emerging trends indicate where conversational AI is headed in the near future:

Multimodal Capabilities: The next generation of chatbots will move beyond text to seamlessly incorporate images, voice, video, and interactive elements. Users will be able to show problems through their camera, hear explanations with visual aids, and interact through whatever medium is most convenient for their current context.

Agentic Behaviors: Advanced chatbots are moving from reactive question-answering to proactive problem-solving. These "agentic" systems can take initiative, break complex tasks into steps, use tools to gather information, and persist until objectives are achieved – more like virtual assistants than simple chatbots.

Memory and Personalization: Future systems will maintain more sophisticated long-term memory of user preferences, past interactions, and relationship history. This persistent understanding will enable increasingly personalized experiences that adapt to individual communication styles, knowledge levels, and needs.

Specialized Domain Experts: While general-purpose chatbots will continue to improve, we're also seeing the emergence of highly specialized systems with deep expertise in specific domains – legal assistants with comprehensive knowledge of case law, medical systems trained on clinical literature, or financial advisors versed in tax codes and regulations.

Collaborative Intelligence: The line between human and AI responsibilities will continue to blur, with more sophisticated collaboration models where chatbots and human experts work together seamlessly, each handling aspects of customer interaction where they excel.

Emotional Intelligence: Advancements in affect recognition and appropriate emotional response generation will create more naturally empathetic interactions. Future systems will better recognize subtle emotional cues and respond with appropriate sensitivity to user needs.

Federated and On-Device Processing: Privacy concerns are driving development of architectures where more processing happens locally on user devices, with less data transmitted to central servers. This approach promises better privacy protection while maintaining sophisticated capabilities.

These advancements will enable new applications across industries. In healthcare, chatbots may serve as continuous health companions, monitoring conditions and coordinating care across providers. In education, they might function as personalized tutors adapting to individual learning styles and progress. In professional services, they could become specialized research assistants that dramatically amplify human expertise.

However, these capabilities will also bring new challenges. More powerful systems will require more sophisticated safety mechanisms. Increasingly human-like interactions will raise new questions about appropriate disclosure of AI identity. And as these systems become more integrated into daily life, ensuring equitable access and preventing harmful dependencies will become important social considerations.

What seems clear is that the line between chatbots and other software interfaces will continue to blur. Natural language is simply the most intuitive interface for many human needs, and as conversational AI becomes more capable, it will increasingly become the default way we interact with digital systems. The future isn't just about better chatbots – it's about conversation becoming the primary human-computer interface for many applications.

Slutsats: Den pågående konversationen

Denna komplexa arkitektur möjliggör upplevelser som skulle ha verkat som science fiction för bara ett decennium sedan – naturliga konversationer med digitala system som kan svara på frågor, lösa problem och utföra åtgärder för vår räkning. Ändå är vi fortfarande i de tidiga kapitlen av denna tekniks utveckling. Funktionerna och tillämpningarna hos konversationsbaserad AI kommer att fortsätta att expandera snabbt under de kommande åren.

För företag och organisationer som vill implementera chattrobotteknik är det avgörande att förstå dessa underliggande komponenter för att sätta realistiska förväntningar, göra välgrundade designval och skapa verkligt värdefulla användarupplevelser. De mest framgångsrika implementeringarna behandlar inte chattrobotar som magiska svarta lådor utan snarare som sofistikerade verktyg vars funktioner och begränsningar måste hanteras noggrant.

För användare som interagerar med dessa system kan en titt bakom kulisserna hjälpa till att avmystifiera vad som ibland känns som teknisk magi. Att förstå de grundläggande principerna för hur moderna chattrobotar fungerar möjliggör mer effektiv interaktion – att veta när de kan hjälpa till, när de kan ha svårt och hur man kommunicerar med dem mest framgångsrikt. Det som kanske är mest anmärkningsvärt med chattrobottekniken är hur snabbt våra förväntningar anpassar sig. Funktioner som skulle ha förvånat oss för några år sedan blir snabbt den baslinje vi tar för given. Denna snabba normalisering visar hur naturligt samtal fungerar som ett gränssnitt – när det görs bra försvinner det helt enkelt, vilket gör att vi fokuserar på att lösa problem och få saker gjorda snarare än att tänka på själva tekniken. I takt med att dessa system fortsätter att utvecklas kommer samtalet mellan människor och maskiner att bli alltmer sömlöst och produktivt – inte att ersätta mänsklig kontakt, utan att öka våra förmågor och frigöra oss att fokusera på de unikt mänskliga aspekterna av vårt arbete och våra liv.