Testa AI på DIN webbplats på 60 sekunder

Se hur vår AI omedelbart analyserar din webbplats och skapar en personlig chatbot - utan registrering. Ange bara din URL och se hur det fungerar!

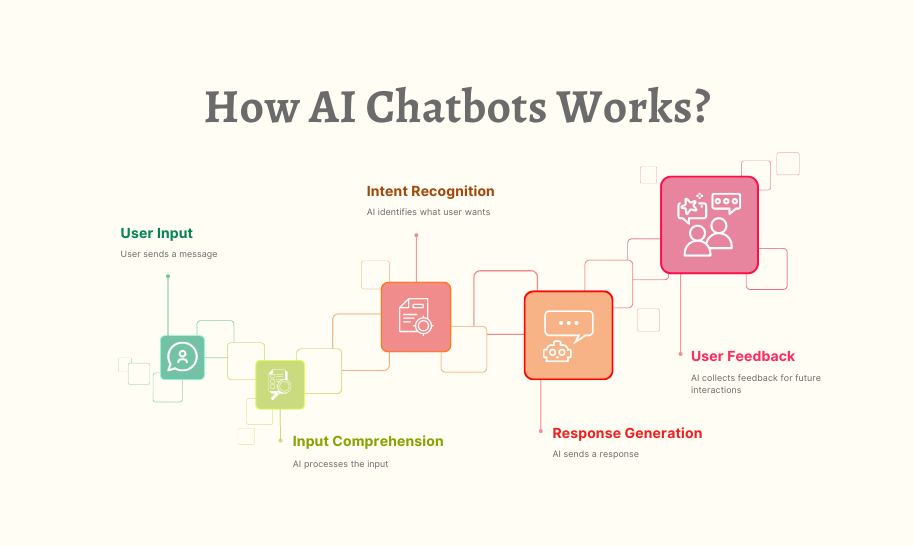

Hur moderna chatbots faktiskt fungerar

Den uppenbara enkelheten hos moderna chatbots döljer en otroligt sofistikerad teknisk orkester som spelar bakom kulisserna. Det som ser ut som ett enkelt textutbyte involverar flera specialiserade AI-system som arbetar tillsammans: bearbetar ditt språk, hämtar relevant information, genererar lämpliga svar och ständigt lärande av interaktioner.

Som någon som har ägnat år åt att utveckla och implementera chatbot-system för olika branscher, har jag haft en plats på första raden till deras anmärkningsvärda utveckling. Många användare är förvånade över att lära sig att moderna chatbots inte är enstaka AI-program utan snarare komplexa ekosystem av specialiserade komponenter som arbetar tillsammans. Att förstå dessa komponenter avmystifierar inte bara vad som ibland kan kännas som teknisk magi utan hjälper oss också att bättre uppskatta både deras möjligheter och begränsningar.

I den här utforskningen kommer vi att dra tillbaka gardinen för moderna chatbots för att förstå nyckelteknologierna som driver dem, hur dessa system tränas och hur de övervinner de grundläggande utmaningarna med mänskligt språk. Oavsett om du funderar på att implementera en chatbot för ditt företag eller helt enkelt är nyfiken på tekniken du interagerar med dagligen, kommer denna rundtur bakom kulisserna att ge värdefulla insikter om en av AI:s mest synliga applikationer.

Stiftelsen: Stora språkmodeller

Skalan på dessa modeller är svår att förstå. De största LLM:erna har hundratals miljarder parametrar – de justerbara värden som modellen använder för att göra förutsägelser. Under utbildningen förfinas dessa parametrar gradvis eftersom modellen bearbetar massiva datamängder bestående av böcker, artiklar, webbplatser, kodlager och annan text – ofta uppgående till biljoner ord.

Genom denna utbildningsprocess utvecklar språkmodeller en statistisk förståelse för hur språk fungerar. De lär sig ordförråd, grammatik, fakta om världen, resonemangsmönster och till och med en viss grad av sunt förnuft. Viktigt är att de inte bara memorerar sina träningsdata – de lär sig generaliserbara mönster som gör att de kan hantera nya input som de aldrig sett förut.

När du skickar ett meddelande till en chatbot som drivs av en LLM, omvandlas din text först till numeriska representationer som kallas tokens. Modellen bearbetar dessa tokens genom sina många lager av neurala anslutningar, vilket i slutändan producerar sannolikhetsfördelningar för vilka tokens som ska komma härnäst i ett svar. Systemet konverterar sedan dessa tokens tillbaka till läsbar text.

De mest avancerade språkmodellerna idag inkluderar:

GPT-4: OpenAIs modell driver ChatGPT och många andra kommersiella applikationer, kända för sina starka resonemangsförmåga och breda kunskap.

Claude: Anthropics familj av modeller, designad med betoning på hjälpsamhet, ofarlighet och ärlighet.

Llama 3: Metas öppna viktmodeller, som har demokratiserat tillgången till kraftfull LLM-teknik.

Gemini: Googles multimodala modeller som kan bearbeta både text och bilder.

Mistral: En familj av effektiva modeller som levererar imponerande prestanda trots mindre parameterantal.

Trots deras anmärkningsvärda kapacitet har bara basspråksmodeller betydande begränsningar som konversationsagenter. De har ingen tillgång till information i realtid, kan inte söka på webben eller databaser för att verifiera fakta och "hallucinerar" ofta – och genererar troligt klingande men felaktig information. Utan ytterligare anpassning saknar de dessutom kunskap om specifika företag, produkter eller användarsammanhang.

Det är därför moderna chatbot-arkitekturer integrerar LLM med flera andra viktiga komponenter för att skapa verkligt användbara konversationssystem.

Hämtningsförstärkt generation: Jorda chatbots i fakta

RAG-system fungerar genom att kombinera den generativa förmågan hos språkmodeller med precisionen hos system för informationshämtning. Så här flyter en typisk RAG-process i en modern chatbot:

Frågebehandling: När en användare ställer en fråga analyserar systemet den för att identifiera nyckelinformationsbehov.

Informationshämtning: Istället för att enbart förlita sig på LLM:s utbildningsdata, söker systemet igenom relevanta kunskapsbaser – som kan inkludera företagsdokumentation, produktkataloger, vanliga frågor eller till och med liveinnehållet på en webbplats.

Val av relevanta dokument: Hämtningssystemet identifierar de mest relevanta dokumenten eller passagerna baserat på semantisk likhet med frågan.

Kontextförstärkning: Dessa hämtade dokument tillhandahålls till språkmodellen som ytterligare sammanhang när dess svar genereras.

Svarsgenerering: LLM producerar ett svar som inkluderar både dess allmänna språkkapacitet och den specifika hämtade informationen.

Källtillskrivning: Många RAG-system spårar också vilka källor som bidrog till svaret, vilket möjliggör citering eller verifiering.

Detta tillvägagångssätt kombinerar det bästa av två världar: LLM:s förmåga att förstå frågor och skapa naturligt språk, med noggrannhet och uppdaterad information från hämtningssystem. Resultatet är en chatbot som kan tillhandahålla specifik faktainformation om produkter, policyer eller tjänster utan att tillgripa hallucinationer.

Överväg en chatbot för e-handel kundtjänst. På frågan om returpolicyer för en specifik produkt kan en ren LLM generera ett rimligt klingande men potentiellt felaktigt svar baserat på allmänna mönster som den observerade under träningen. En RAG-förbättrad chatbot skulle istället hämta företagets faktiska returpolicydokument, hitta det relevanta avsnittet om den produktkategorin och generera ett svar som korrekt återspeglar den nuvarande policyn.

RAG-systemens sofistikering fortsätter att utvecklas. Moderna implementeringar använder täta vektorinbäddningar för att representera både frågor och dokument i högdimensionellt semantiskt utrymme, vilket möjliggör hämtning baserat på mening snarare än bara sökordsmatchning. Vissa system använder återvinningsrörledningar i flera steg, först kastar ett brett nät och sedan förfinar resultaten genom omrangering. Andra avgör dynamiskt när hämtning är nödvändig jämfört med när LLM säkert kan svara utifrån sin parametriska kunskap.

För företag som implementerar chatbots kräver effektiv RAG-implementering genomtänkta kunskapsbasförberedelser – organisera information i återhämtningsbara bitar, regelbundet uppdatera innehåll och strukturera data på ett sätt som underlättar korrekt hämtning. När det är korrekt implementerat förbättrar RAG dramatiskt chatbot-noggrannheten, särskilt för domänspecifika applikationer där precision är avgörande.

Conversational State Management: Att upprätthålla sammanhang

Moderna chatbots använder sofistikerade konversationstillståndshanteringssystem för att upprätthålla sammanhängande, kontextuella utbyten. Dessa system spårar inte bara det explicita innehållet i meddelanden utan också det implicita sammanhanget som människor naturligt upprätthåller under konversationer.

Den mest grundläggande formen av statlig förvaltning är spårning av samtalshistorik. Systemet upprätthåller en buffert av de senaste utbytena (både användarinmatningar och dess egna svar) som tillhandahålls till språkmodellen med varje ny fråga. Men när konversationer blir längre, blir hela historien opraktisk på grund av kontextlängdbegränsningarna för även de mest avancerade LLM:erna.

För att hantera denna begränsning använder sofistikerade chatbots flera tekniker:

Sammanfattning: Regelbundet kondensera tidigare delar av konversationen till kortfattade sammanfattningar som fångar nyckelinformation samtidigt som tokenanvändningen minskar.

Entitetsspårning: Övervakar explicit viktiga enheter (personer, produkter, frågor) som nämns under hela konversationen och bibehåller dem i ett strukturerat tillstånd.

Medvetenhet om konversationsstadiet: Spåra var i ett processflöde konversationen för närvarande befinner sig – oavsett om man samlar in information, föreslår lösningar eller bekräftar åtgärder.

Användarkontextbeständighet: Upprätthåller relevant användarinformation över sessioner, såsom inställningar, köphistorik eller kontodetaljer (med lämpliga integritetskontroller).

Avsiktsminne: Att komma ihåg användarens ursprungliga mål även genom samtalsomvägar och förtydliganden.

Tänk på ett kundtjänstscenario: En användare börjar fråga om att uppgradera sin prenumerationsplan och ställer sedan flera detaljerade frågor om funktioner, prisjämförelser och faktureringscykler, innan han slutligen bestämmer sig för att fortsätta med uppgraderingen. Ett effektivt hanteringssystem för konversationstillstånd säkerställer att när användaren säger "Ja, låt oss göra det", förstår chatboten exakt vad "det" refererar till (uppgraderingen) och har behållit alla relevanta detaljer från den slingrande konversationen.

Den tekniska implementeringen av statlig förvaltning varierar mellan olika plattformar. Vissa system använder ett hybridt tillvägagångssätt, som kombinerar symbolisk tillståndsspårning (explicit modellering av enheter och avsikter) med de implicita funktionerna hos stora sammanhangsfönster i moderna LLM:er. Andra använder specialiserade minnesmoduler som selektivt hämtar relevanta delar av konversationshistoriken baserat på den aktuella frågan.

För komplexa applikationer som kundservice eller försäljning, integreras statlig ledning ofta med affärsprocessmodellering, vilket gör att chatbots kan guida konversationer genom definierade arbetsflöden samtidigt som flexibiliteten för naturlig interaktion bibehålls. De mest avancerade implementeringarna kan till och med spåra känslomässigt tillstånd tillsammans med faktasammanhang, och justera kommunikationsstilen baserat på upptäckta användarsentiment.

Effektiv kontexthantering förvandlar chatbot-interaktioner från bortkopplade fråge-svar-utbyten till genuina konversationer som bygger på delad förståelse – en kritisk faktor för användarnas tillfredsställelse och slutförandet av uppgifter.

Naturlig språkförståelse: Tolka användaravsikter

Moderna NLU-system i chatbots utför vanligtvis flera nyckelfunktioner:

Intent Recognition: Identifiera användarens underliggande mål eller syfte. Försöker användaren göra ett köp, rapportera ett problem, begära information eller något annat? Avancerade system kan känna igen flera eller kapslade avsikter i ett enda meddelande.

Entity Extraction: Identifiera och kategorisera specifika delar av information i användarens meddelande. Till exempel, i "Jag behöver ändra mitt flyg från Chicago till Boston på torsdag" inkluderar enheterna platser (Chicago, Boston) och tid (torsdag).

Sentimentanalys: Upptäcker känslomässig ton och attityd, vilket hjälper chatboten att anpassa sin svarsstil på lämpligt sätt. Är användaren frustrerad, upphetsad, förvirrad eller neutral?

Språkidentifiering: Bestämmer vilket språk användaren talar för att ge lämpliga svar i flerspråkiga miljöer.

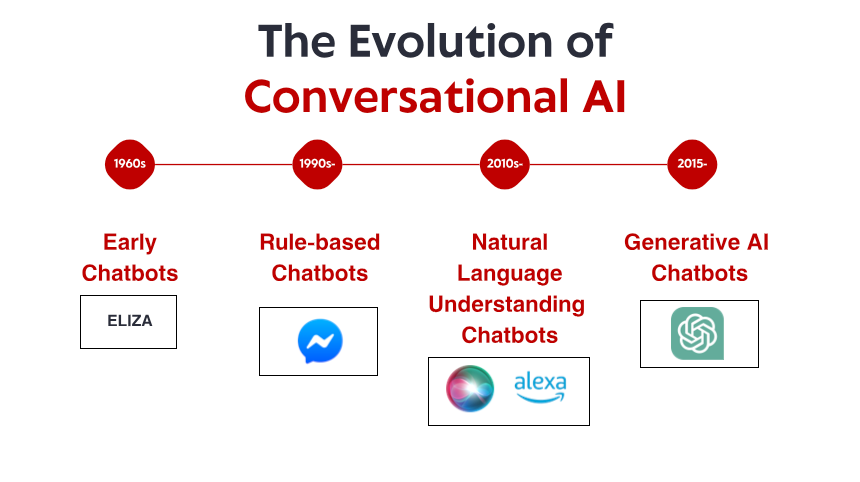

Medan tidigare chatbotplattformar krävde explicit programmering av avsikter och enheter, utnyttjar moderna system den inneboende språkförståelsekapaciteten hos LLM. Detta gör att de kan hantera ett mycket bredare utbud av uttryck utan att kräva uttömmande uppräkning av möjliga fraser.

När en användare skriver "Kasseprocessen fortsätter att frysa på betalningssidan", skulle ett sofistikerat NLU-system identifiera detta som en teknisk supportavsikt, extrahera "utcheckningsprocess" och "betalningssida" som relevanta enheter, upptäcka frustration i känslan och dirigera denna information till lämplig svarsgenereringsväg.

Noggrannheten hos NLU påverkar avsevärt användarnas tillfredsställelse. När en chatbot konsekvent feltolkar förfrågningar tappar användarna snabbt förtroende och tålamod. För att förbättra noggrannheten använder många system konfidenspoäng – när förtroendet för förståelse faller under vissa trösklar, kan chatboten ställa förtydligande frågor snarare än att fortsätta med potentiellt felaktiga antaganden.

För domänspecifika applikationer innehåller NLU-system ofta specialiserad terminologi och jargongigenkänning. En chatbot för sjukvården, till exempel, skulle tränas i att känna igen medicinska termer och symtom, medan en bot för finansiella tjänster skulle förstå bankterminologi och transaktionstyper.

Integreringen av NLU med de andra komponenterna är avgörande. De extraherade avsikterna och enheterna informerar hämtningsprocesser, hjälper till att upprätthålla konversationstillstånd och vägleder generering av svar – och fungerar som den kritiska länken mellan vad användare säger och vad systemet gör.

Testa AI på DIN webbplats på 60 sekunder

Se hur vår AI omedelbart analyserar din webbplats och skapar en personlig chatbot - utan registrering. Ange bara din URL och se hur det fungerar!

Generering och optimering av svar

I moderna system innefattar svarsgenerering vanligtvis flera steg:

Svarsplanering: Bestämma vilken information som ska inkluderas, frågor att ställa eller åtgärder som ska föreslås baserat på det aktuella konversationsläget och tillgänglig kunskap.

Innehållsurval: Välj vilka specifika fakta, förklaringar eller alternativ som ska presenteras från potentiellt stora uppsättningar relevant information.

Strukturering: Organisera det valda innehållet i en logisk, lätt att följa sekvens som tillgodoser användarens behov effektivt.

Realisering: Konvertera det planerade innehållet till ett naturligt, flytande språk som matchar den önskade tonen och stilen hos chatboten.

Även om LLM:er kan generera imponerande sammanhängande text, leder okontrollerad generering ofta till problem som överdriven detaljerad information, inkludering av irrelevant information eller svar som inte stämmer överens med affärsmålen. För att lösa dessa problem implementerar sofistikerade chatbotsystem olika optimeringstekniker:

Svarsmallar: För vanliga scenarier med förutsägbara informationsbehov använder många system parametriserade mallar som säkerställer konsekventa, effektiva svar samtidigt som det tillåter personalisering.

Längdkontroll: Mekanismer för att justera svarslängden baserat på frågans komplexitet, plattformen där interaktionen sker och användarpreferenser.

Ton- och stilvägledning: Instruktioner som justerar svarens formalitet, vänlighet eller tekniska nivå baserat på konversationskontexten och användaregenskaper.

Planering med flera svängar: För komplexa ämnen kan system planera svar över flera varv, avsiktligt dela upp information i lättsmälta bitar snarare än att överväldiga användare med textväggar.

Business Logic Integration: Regler som säkerställer att svar överensstämmer med affärspolicyer, regulatoriska krav och tjänstemöjligheter.

De mest effektiva chatbotarna använder också adaptiva svarsstrategier. De övervakar användarens engagemang och nöjdhetssignaler för att förfina sitt kommunikationssätt över tid. Om användare ofta ber om förtydliganden efter en viss typ av svar, kan systemet automatiskt anpassa sig för att ge mer detaljerade förklaringar i liknande framtida scenarier.

En avgörande aspekt av svarsgenerering är att hantera osäkerhet. När informationen är otillgänglig eller tvetydig, erkänner väldesignade system begränsningar snarare än att generera självsäkert klingande men potentiellt felaktiga svar. Denna transparens skapar förtroende och hanterar användarnas förväntningar effektivt.

För verksamhetskritiska applikationer som sjukvård eller finansiella tjänster inkluderar många implementeringar mänskliga granskningsmekanismer för vissa typer av svar innan de når användarna. Dessa skyddsräcken ger ett extra lager av kvalitetskontroll för interaktioner med hög insats.

Specialiserade moduler för åtgärder och integration

Dessa handlingsmöjligheter implementeras genom specialiserade moduler som kopplar samman samtalsgränssnittet med externa system:

API Integration Framework: Ett mellanprogramlager som översätter konversationsförfrågningar till korrekt formaterade API-anrop till olika backend-tjänster – beställningssystem, CRM-plattformar, betalningsprocessorer, reservationssystem, etc.

Autentisering och auktorisering: Säkerhetskomponenter som verifierar användaridentitet och behörighetsnivåer innan de utför känsliga åtgärder eller får åtkomst till skyddad information.

Formfilling Assistance: Moduler som hjälper användare att fylla i komplexa formulär genom samtalsinteraktion, samla in nödvändig information bit för bit istället för att presentera överväldigande formulär.

Transaktionsbearbetning: Komponenter som hanterar flerstegsprocesser som köp, bokningar eller kontoändringar, bibehåller status under hela processen och hanterar undantag på ett elegant sätt.

Notifieringssystem: Möjlighet att skicka uppdateringar, bekräftelser eller varningar via olika kanaler (e-post, SMS, aviseringar i appen) när åtgärder fortskrider eller slutförs.

De sofistikerade integrationerna varierar kraftigt mellan olika implementeringar. Enkla chatbots kan innehålla grundläggande "handoff"-funktioner som överför användare till mänskliga agenter eller specialiserade system när åtgärder krävs. Mer avancerade implementeringar erbjuder sömlösa end-to-end-upplevelser där chatboten hanterar hela processen i konversationen.

Överväg att en flygbolags chatbot hjälper en passagerare att byta flyg. Det behöver:

Autentisera användaren och hämta deras bokning

Sök efter tillgängliga alternativa flyg

Beräkna eventuella prisskillnader eller ändringsavgifter

Behandla betalning vid behov

Utfärda nya boardingkort

Uppdatera reservationen i flera system

Skicka bekräftelseinformation via föredragna kanaler

För att uppnå detta krävs integration med bokningssystem, betalningsprocessorer, autentiseringstjänster och meddelandeplattformar – allt orkestrerat av chatboten samtidigt som ett naturligt konversationsflöde bibehålls.

För företag som bygger handlingsorienterade chatbots representerar detta integrationslager ofta den mest betydande utvecklingsinsatsen. Även om konversationskomponenterna drar nytta av framsteg inom allmän AI, måste dessa integrationer skräddarsys för varje organisations specifika systemlandskap.

Säkerhetsaspekter är särskilt viktiga för action-kapabla chatbots. Bästa praxis inkluderar att implementera korrekt autentisering före känsliga operationer, upprätthålla detaljerade granskningsloggar över alla åtgärder som vidtagits, tillhandahålla tydliga bekräftelsesteg för följdaktiviteter och designa elegant felhantering när integrationer stöter på problem.

I takt med att dessa integrationsmöjligheter utvecklas, fortsätter gränsen mellan konversationsgränssnitt och traditionella applikationer att suddas ut. De mest sofistikerade implementeringarna idag tillåter användare att utföra komplexa uppgifter helt och hållet genom naturliga samtal som tidigare skulle ha krävt att navigera på flera skärmar i traditionella applikationer.

Utbildning och ständig förbättring

Flera tillvägagångssätt för träning och förbättringsarbete i samverkan:

Grundmodellfinjustering: Basspråksmodellerna som driver chatbots kan specialiseras ytterligare genom ytterligare utbildning om domänspecifika data. Denna process, som kallas finjustering, hjälper modellen att anta lämplig terminologi, resonemangsmönster och domänkunskap för specifika tillämpningar.

Förstärkning att lära sig av mänsklig feedback (RLHF): Denna teknik använder mänskliga utvärderare för att betygsätta modellsvar och skapa preferensdata som tränar belöningsmodeller. Dessa belöningsmodeller vägleder sedan systemet mot att generera mer användbara, exakta och säkra utdata. RLHF har varit avgörande för att flytta språkmodeller från imponerande men opålitliga generatorer till praktiska assistenter.

Conversation Mining: Analytics-system som behandlar anonymiserade konversationsloggar för att identifiera mönster, vanliga frågor, frekventa felpunkter och framgångsrika lösningsvägar. Dessa insikter driver både automatiserade förbättringar och vägleder mänskliga förbättringar.

Aktivt lärande: System som identifierar områden med osäkerhet och flaggar dessa fall för mänsklig granskning, och fokuserar mänskliga ansträngningar på de mest värdefulla förbättringsmöjligheterna.

A/B-testning: Experimentella ramverk som jämför olika svarsstrategier med verkliga användare för att avgöra vilka metoder som är mest effektiva för olika scenarier.

För företagschattbotar börjar utbildningsprocessen vanligtvis med historiska data – tidigare kundtjänstutskrifter, dokumentation och produktinformation. Denna inledande utbildning kompletteras sedan med noggrant utformade exempelsamtal som demonstrerar idealisk hantering av vanliga scenarier.

När de väl har implementerats inkluderar effektiva system återkopplingsmekanismer som tillåter användare att ange om svaren var till hjälp. Denna feedback, i kombination med implicita signaler som att konversation överges eller upprepade frågor, skapar en rik datauppsättning för ständiga förbättringar.

Den mänskliga rollen i att träna moderna chatbots är fortfarande viktig. Konversationsdesigners skapar kärnpersonligheten och kommunikationsmönstren. Ämnesexperter granskar och korrigerar föreslagna svar för teknisk noggrannhet. Dataforskare analyserar prestationsmått för att identifiera förbättringsmöjligheter. De mest framgångsrika implementeringarna behandlar chatbotutveckling som ett samarbetande human-AI-partnerskap snarare än en helt automatiserad process.

För företag som implementerar chatbots är det avgörande att skapa ett tydligt förbättringsramverk. Detta inkluderar:

Regelbundna prestandagenomgångscykler

Dedikerad personal för övervakning och förfining

Tydliga mått för framgång

Processer för att införliva användarfeedback

Styrning för hantering av utbildningsdatakvalitet

Även om de specifika tillvägagångssätten varierar mellan plattformar och applikationer, förblir den grundläggande principen konsekvent: moderna chatbots är dynamiska system som förbättras genom användning, feedback och avsiktlig förfining snarare än statiska program som är låsta i deras ursprungliga kapacitet.

Säkerhetsåtgärder och etiska överväganden

Dessa skyddsåtgärder inkluderar vanligtvis:

Innehållsfiltrering: System som upptäcker och förhindrar skadligt, stötande eller olämpligt innehåll i både användarinmatningar och modellutgångar. Moderna implementeringar använder specialiserade modeller som är speciellt utbildade för att identifiera problematiskt innehåll i olika kategorier.

Tillämpning av omfattning: Mekanismer som håller konversationer inom lämpliga domäner, förhindrar att chatbotar manipuleras för att ge råd eller information utanför deras avsedda syfte och expertis.

Datasekretesskontroller: Skydd för känslig användarinformation, inklusive dataminimeringsprinciper, anonymiseringstekniker och mekanismer för uttryckligt samtycke för datalagring eller användning.

Bias Mitigation: Processer som identifierar och minskar orättvisa fördomar i utbildningsdata och modellutdata, vilket säkerställer rättvis behandling av olika användargrupper.

Extern referensverifiering: För faktiska påståenden, särskilt inom känsliga domäner, system som verifierar information mot pålitliga externa källor innan de presenteras för användare.

Mänsklig övervakning: För kritiska tillämpningar, granska mekanismer som möjliggör mänsklig övervakning och ingripande vid behov, särskilt för följdbeslut eller känsliga ämnen.

Genomförandet av dessa skyddsåtgärder omfattar både tekniska och politiska komponenter. På teknisk nivå samverkar olika filtreringsmodeller, detektionsalgoritmer och övervakningssystem för att identifiera problematiska interaktioner. På policynivå definierar tydliga riktlinjer lämpliga användningsfall, obligatoriska friskrivningar och eskaleringsvägar.

Sjukvårdens chatbots ger ett tydligt exempel på dessa principer i praktiken. Väldesignade system inom den här domänen inkluderar vanligtvis uttryckliga friskrivningar om deras begränsningar, undviker diagnostiskt språk såvida det inte är medicinskt validerat, upprätthåller strikta integritetskontroller för hälsoinformation och inkluderar tydliga eskaleringsvägar till medicinsk personal för lämpliga problem.

För företag som implementerar chatbots har flera bästa praxis dykt upp:

Börja med tydliga etiska riktlinjer och använd fallgränser

Implementera flera lager av säkerhetsmekanismer snarare än att förlita dig på ett enda tillvägagångssätt

Testa utförligt med olika användargrupper och scenarier

Upprätta protokoll för övervakning och incidentrespons

Ge transparent information till användarna om systemets möjligheter och begränsningar

När konversations-AI blir mer kraftfull ökar betydelsen av dessa skyddsåtgärder bara. De mest framgångsrika implementeringarna balanserar innovation med ansvar, vilket säkerställer att chatbots förblir användbara verktyg som förbättrar mänskliga förmågor snarare än att skapa nya risker eller skador.

Framtiden för chatbotteknik

Multimodala funktioner: Nästa generation av chatbots kommer att gå bortom text för att sömlöst införliva bilder, röst, video och interaktiva element. Användare kommer att kunna visa problem genom sin kamera, höra förklaringar med visuella hjälpmedel och interagera genom vilket medium som är mest praktiskt för deras nuvarande sammanhang.

Agentbeteende: Avancerade chatbots går från reaktiva frågesvar till proaktiv problemlösning. Dessa "agentiska" system kan ta initiativ, dela upp komplexa uppgifter i steg, använda verktyg för att samla information och fortsätta tills målen uppnås – mer som virtuella assistenter än enkla chatbots.

Minne och personalisering: Framtida system kommer att upprätthålla ett mer sofistikerat långtidsminne av användarpreferenser, tidigare interaktioner och relationshistorik. Denna ihärdiga förståelse kommer att möjliggöra allt mer personliga upplevelser som anpassar sig till individuella kommunikationsstilar, kunskapsnivåer och behov.

Specialiserade domänexperter: Även om chatbotar för allmänna ändamål kommer att fortsätta att förbättras, ser vi också uppkomsten av högspecialiserade system med djup expertis inom specifika domäner – juridiska assistenter med omfattande kunskap om rättspraxis, medicinska system utbildade i klinisk litteratur eller finansiella rådgivare som är bevandrade i skatteregler och regler.

Collaborative Intelligence: Gränsen mellan mänskligt och AI-ansvar kommer att fortsätta att suddas ut, med mer sofistikerade samarbetsmodeller där chatbotar och mänskliga experter samarbetar sömlöst, var och en hanterar aspekter av kundinteraktion där de utmärker sig.

Emotionell intelligens: Framsteg i affektigenkänning och lämplig generering av känslomässiga svar kommer att skapa mer naturligt empatiska interaktioner. Framtida system kommer bättre att känna igen subtila känslomässiga signaler och svara med lämplig lyhördhet för användarnas behov.

Federerad och on-Device Processing: Sekretessproblem driver utvecklingen av arkitekturer där mer bearbetning sker lokalt på användarenheter, med mindre data som överförs till centrala servrar. Detta tillvägagångssätt lovar bättre integritetsskydd samtidigt som sofistikerade funktioner bibehålls.

Dessa framsteg kommer att möjliggöra nya tillämpningar inom olika branscher. Inom vården kan chatbots fungera som kontinuerliga hälsokompisar, övervaka förhållanden och samordna vård mellan leverantörer. Inom utbildning kan de fungera som personliga handledare som anpassar sig till individuella inlärningsstilar och framsteg. Inom professionella tjänster kan de bli specialiserade forskningsassistenter som dramatiskt förstärker mänsklig expertis.

Men dessa förmågor kommer också att medföra nya utmaningar. Kraftfullare system kommer att kräva mer sofistikerade säkerhetsmekanismer. Allt mer människoliknande interaktioner kommer att väcka nya frågor om lämpligt avslöjande av AI-identitet. Och när dessa system blir mer integrerade i det dagliga livet, kommer det att bli viktiga sociala överväganden att säkerställa rättvis tillgång och förhindra skadliga beroenden.

Det som verkar tydligt är att gränsen mellan chatbots och andra mjukvarugränssnitt kommer att fortsätta att suddas ut. Naturligt språk är helt enkelt det mest intuitiva gränssnittet för många mänskliga behov, och i takt med att konversations-AI blir mer kapabel kommer det i allt högre grad att bli standardsättet vi interagerar med digitala system. Framtiden handlar inte bara om bättre chatbots – det handlar om att konversation blir det primära gränssnittet mellan människa och dator för många applikationer.

Slutsats: Det pågående samtalet

Moderna chatbots representerar en av de mest synliga och effektfulla tillämpningarna av artificiell intelligens i vardagen. Bakom deras till synes enkla chattgränssnitt döljer sig en sofistikerad orkester av teknologier som samverkar: grundmodeller som ger språkförståelse, hämtningssystem som jordar svar i korrekt information, statlig ledning som upprätthåller sammanhängande konversationer, integrationsskikt som ansluter till affärssystem och säkerhetsmekanismer som säkerställer lämpligt beteende.

Denna komplexa arkitektur möjliggör upplevelser som skulle ha verkat som science fiction för bara ett decennium sedan – naturliga samtal med digitala system som kan svara på frågor, lösa problem och utföra åtgärder för vår räkning. Och ändå är vi fortfarande i de tidiga kapitlen av denna tekniks utveckling. Möjligheterna och tillämpningarna av konversations-AI kommer att fortsätta att expandera snabbt under de kommande åren.

För företag och organisationer som vill implementera chatbot-teknik är det avgörande att förstå dessa underliggande komponenter för att sätta realistiska förväntningar, göra välgrundade designval och skapa verkligt värdefulla användarupplevelser. De mest framgångsrika implementeringarna behandlar inte chatbots som magiska svarta lådor utan snarare som sofistikerade verktyg vars möjligheter och begränsningar måste hanteras eftertänksamt.

För användare som interagerar med dessa system kan en glimt bakom ridån hjälpa till att avmystifiera vad som ibland känns som teknisk magi. Att förstå de grundläggande principerna för hur moderna chatbots fungerar möjliggör effektivare interaktion – att veta när de kan hjälpa, när de kan kämpa och hur man kommunicerar med dem mest framgångsrikt.

Det som kanske är mest anmärkningsvärt med chatbottekniken är hur snabbt våra förväntningar anpassar sig. Funktioner som skulle ha förvånat oss för några år sedan blir snabbt den baslinje vi tar för givet. Denna snabba normalisering talar om hur naturligt konversation fungerar som ett gränssnitt – när det görs bra försvinner det helt enkelt, vilket gör att vi fokuserar på att lösa problem och få saker gjorda snarare än att tänka på själva tekniken.

I takt med att dessa system fortsätter att utvecklas kommer samtalet mellan människor och maskiner att bli allt mer sömlöst och produktivt – inte ersätta mänsklig kontakt, utan utöka våra möjligheter och frigöra oss att fokusera på de unikt mänskliga aspekterna av vårt arbete och liv.